A Cohere for AI, a Cohere Inc. által vezetett nonprofit kutatólabor mutatta be nem rég az Aya nevű, „masszívan többnyelvű” nyílt forráskódú mesterséges intelligencia nagy nyelvi modelljét (LLM), amely 101 különböző nyelven képes beszélni.

A Cohere szerint az Aya több mint 100 nyelv támogatásával kétszer annyi nyelvet képes kezelni, mint a jelenleg létező alternatív nyílt forráskódú modellek. Ez azért nagyon fontos számunkra, mert a magyar nyelv (a felhasználók számából és bonyolultságból adódóan) viszonylag alulreprezentált a nyílt forrású AI-k térképen.

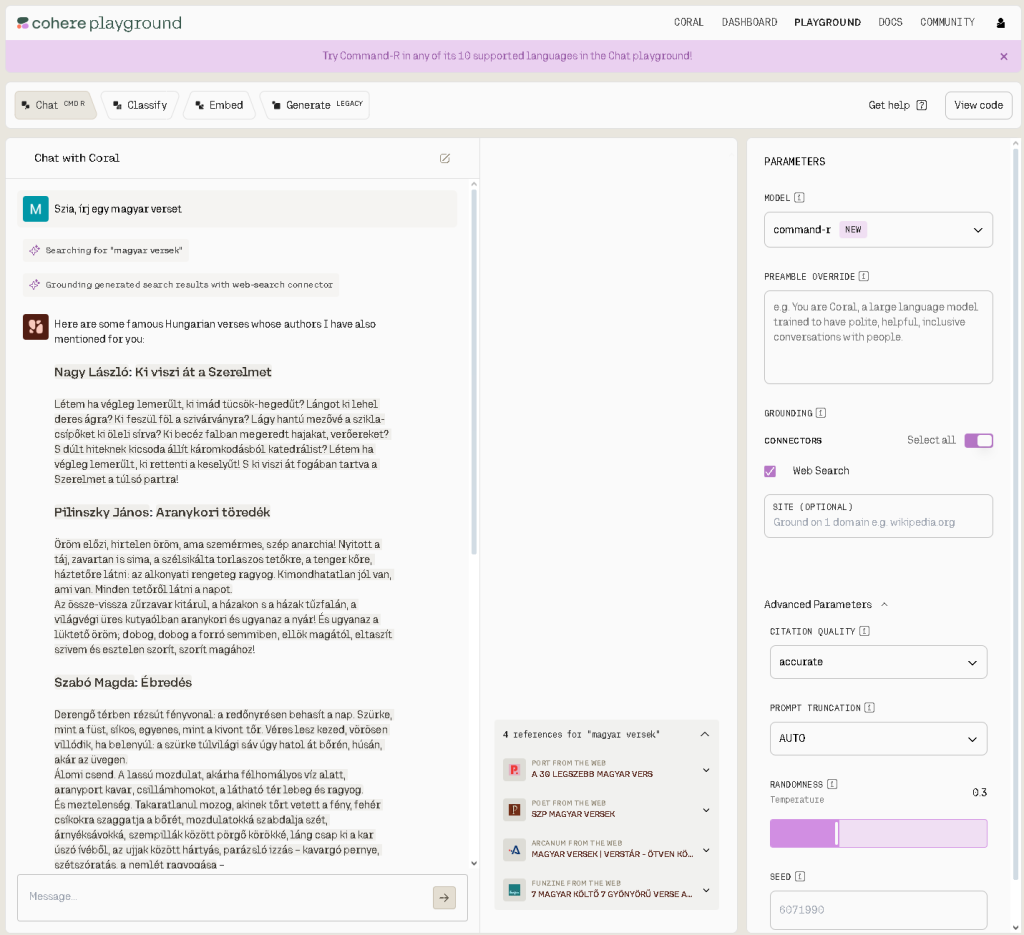

Az Aya ki is próbálható (ráadásul ez a csapat aktívan kísérletezik a válaszok megalapozásával (grounding), illetve a modell tanításába be is lehet csatlakozni (bátorítanék és mindenkit!): https://aya.for.ai/.

Aya többnyelvű modell

Az Aya modell azonos nevű projektből származik, amelyet 2023 januárjában indítottak több mint 3 000 kutatóval 119 országban azzal a szándékkal, hogy építsenek egy többnyelvű generatív AI modellt, amely az egész világról érkező emberek hozzájárulásaira épül. Bár sok modell az angol nyelvre összpontosít, csupán a világ népességének körülbelül 5%-a beszél angolul otthon. A nyelvkutató központ, az Ethnologue szerint jelenleg több mint 7 000 nyelvet beszélnek a világon. Ebből 23 nyelv (beleértve az angolt is), több mint a világ népességének felét képviseli. A nyelvek körülbelül 40%-a veszélyeztetett, soknak kevesebb mint 1 000 beszélője van.

Érdekes ezzel szembeállítani azt a tényt is, hogy a Google legújabb Gemini modellje akkora munkamemóriával rendelkezik (1 millió token nagyságú kontextus ablak), hogy gyakorlatilag képes egy beszélgetésben megtanulni egy nyelvet.

Adatkészlet és annotációk

Az Aya mellett a Cohere a legnagyobb, eddig ismert többnyelvű utasítás adatkészletét is közzéteszi (a tanító adatkészletet ritkán teszik közzé!), amely 513 millió adatpontot tartalmaz, és 114 különböző nyelvet fed le. Az adatkészlet tartalmazza az alulreprezentált nyelveket és ritka annotációkat, így gyorsabb kezdést biztosít más kutatóknak is. A közzétett adatkészlet 204 000 ritka, ember által ellenőrzött annotációt tartalmaz 67 nyelven. Az annotációkat az AI modellek hatékony tanulásának segítésére használják azáltal, hogy kontextust adnak az adatokhoz a nyelv megértéséhez, például a kategorizáláshoz és a megértés pontosságának növeléséhez. Az adatkészlet több mint 50 korábban alulreprezentált nyelvet is lefed, mint például a szomáli és az üzbég.

Jó eredmények

A kutatók azt mondták, hogy a modell jól teljesített más masszívan többnyelvű modellekkel szembeni tesztekben, és felülmúlta az egyéb nyílt forráskódú modelleket, beleértve az mT0-t és a BigScience Bloomz-t a teszteken. Az Aya 75%-ban teljesített jól az emberi értékelésekben a „vezető nyílt forráskódú modellekkel” szemben, és 80%-tól 90%-ig a szimulált győzelmi arányokban.

Elérhető, próbára érdemes nyelvi modelleket és eszközöket tartalmazó listám itt található, illetve az LLM-ek lelki világáról (prompt engineering) itt lehet még olvasni.

Források: