Címke: gépi tanulás

-

Véleményem a Sora-ról (és az első mémem)

Hetek óta tervezem ezt a posztot, nagyjából mióta kijött a Sora. A készítők szerint… Érdemes elolvasni a kapcsolódó hosszabb OpenAI posztot is, ahol készítők maguk világ szimulátornak nevezik a modellt (#hellosimulation, és amúgy a jelenlegi AI-k is inkább intelligencia szimulátorok szerintem). Ők ilyeneket írnak: …és szerintem is Mi tulajdonképpen az OpenAI Sora modellje? Videó generátor?…

-

Aya: A nyelvi korlátokat ledöntő open source AI projekt

A Cohere for AI, a Cohere Inc. által vezetett nonprofit kutatólabor mutatta be nem rég az Aya nevű, „masszívan többnyelvű” nyílt forráskódú mesterséges intelligencia nagy nyelvi modelljét (LLM), amely 101 különböző nyelven képes beszélni. A Cohere szerint az Aya több mint 100 nyelv támogatásával kétszer annyi nyelvet képes kezelni, mint a jelenleg létező alternatív nyílt…

-

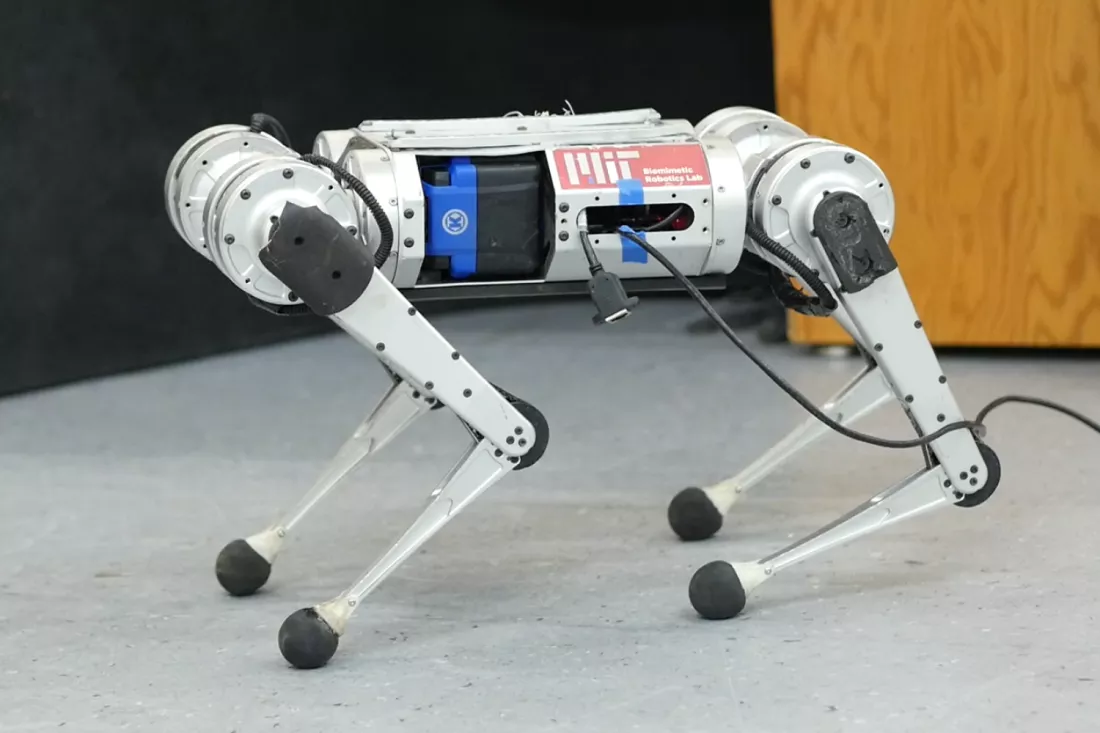

Ez a robot megtanult járni II.

Régen írtam az AI és a robotika kapcsolatáról, mely folyamatosan intenzívebbé és mélyebbé válik, sokak szerint 2024 a robotika éve lehet. Már 2022-ben programozás helyett tanították a robotokat járni, melyről itt írtam. Néhány hónapja az NVidia számolt be arról, hogy a GPT4 (fizetős ChatGPT) által finomhangolt virtuális környezetben (párhuzamosan akár több százban) tanítottak ceruza pörgetést…

-

ChatGPT vs. Bing Chat AI

Az OpenAI ChatGPT modellje nagyot szólt, és már béta tesztelhető a Microsoft boszorkánykonyhájában saját ízlésük szerint finomhangolt, de OpenAI technológiát is alkalmazó verzió az „új Bing”, avagy Bing Chat. Legnagyobb különbség, hogy míg a ChatGPT jelenleg csak egy fix, 2021-ben lezárt tudásanyaggal dolgozik, a Bing valós időben is képes az interneten keresni, és akár napi…

-

Ez a robot megtanult járni

Gépi tanulás: Ez a robot nem beégetett programkóddal, hanem magától tanult meg járni, futni, bárhol. Az eredmény? Rekord sebesség!